Maksimal Sannsynlighet Estimering > EM Algoritme (Forventning-maksimering)

Du vil kanskje lese denne artikkelen først: Hva Er Maksimal Sannsynlighet Estimering?

HVA ER Em-Algoritmen?

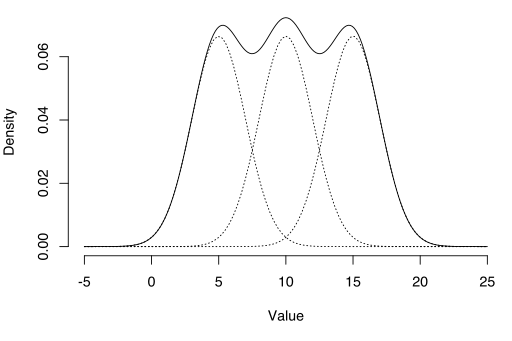

EM-algoritmen kan brukes til å estimere latente variabler, som de som kommer fra blandingsfordelinger (du vet at de kom fra en blanding, men ikke hvilken spesifikk distribusjon).

Forventning-Maksimering (EM) algoritmen er en måte å finne maksimal sannsynlighet estimater for modellparametere når dataene er ufullstendige, har manglende datapunkter, eller har uobserverte (skjulte) latente variabler. Det er en iterativ måte å tilnærme maksimal sannsynlighetsfunksjon. Mens maksimal sannsynlighetsestimering kan finne den «beste passformen» – modellen for et sett med data, fungerer det ikke spesielt godt for ufullstendige datasett. Den mer komplekse em-algoritmen kan finne modellparametere selv om du mangler data. Det fungerer ved å velge tilfeldige verdier for de manglende datapunktene, og bruke disse gjetningene til å estimere et annet sett med data. De nye verdiene brukes til å skape et bedre gjetning for det første settet, og prosessen fortsetter til algoritmen konvergerer på et fast punkt.

Se OGSÅ: Em Algoritme forklart i ett bilde.

MLE vs. EM

Selv Om Maksimal Sannsynlighet Estimering (Mle) og EM kan både finne» best-fit » parametere, hvordan de finner modellene er svært forskjellige. MLE samler alle dataene først og bruker deretter dataene til å konstruere den mest sannsynlige modellen. EM tar en gjetning på parametrene først-regnskap for manglende data – deretter tweaks modellen for å passe gjetninger og observerte data. De grunnleggende trinnene for algoritmen er:

- en innledende gjetning er laget for modellens parametere og en sannsynlighetsfordeling opprettes. Dette kalles Noen Ganger «E-Trinn «for» Forventet » distribusjon.

- nylig observerte data mates inn i modellen.

- sannsynlighetsfordelingen Fra e-trinnet er justert for å inkludere de nye dataene. Dette kalles noen ganger » m-trinnet.»

- Trinn 2 til 4 gjentas til stabilitet (dvs.en fordeling som ikke endres Fra E-trinnet Til M-trinnet) er nådd.

EM-Algoritmen forbedrer alltid en parameterestimering gjennom denne flertrinnsprosessen. Imidlertid trenger det noen ganger noen tilfeldige begynner å finne den beste modellen fordi algoritmen kan finpusse på en lokal maksima som ikke er så nær den (optimale) globale maksima. Med andre ord kan det fungere bedre hvis du tvinger det til å starte på nytt og ta det «første gjetning» Fra Trinn 1 igjen. Fra alle mulige parametere kan du deretter velge den med størst maksimal sannsynlighet.

i virkeligheten innebærer trinnene noen ganske tunge kalkulus (integrasjon) og betingede sannsynligheter, som er utenfor rammen av denne artikkelen. Hvis du trenger en mer teknisk (dvs. kalkulusbasert) sammenbrudd av prosessen, anbefaler jeg at Du leser Gupta Og Chens 2010-papir.

Applikasjoner

EM-algoritmen har mange applikasjoner, inkludert:

- dis-entangling overliggende signaler,

- Estimering Av Gaussiske blandingsmodeller (Gmm),

- Estimering av skjulte Markov-modeller (Hmm),

- Estimering av parametere for sammensatte Dirichlet-fordelinger,

- Å Finne optimale blandinger av faste modeller.

Begrensninger

em-algoritmen kan være veldig treg, selv på den raskeste datamaskinen. Det fungerer best når du bare har en liten prosentandel av manglende data og dimensjonaliteten til dataene ikke er for stor. Jo høyere dimensjonalitet, jo langsommere E-trinnet; for data med større dimensjonalitet kan Du finne At e-trinnet går ekstremt sakte da prosedyren nærmer seg et lokalt maksimum.

Dempster, A., Laird, N. og Rubin, D. (1977) Maksimal sannsynlighet fra ufullstendige data via EM-algoritmen, Journal Of The Royal Statistical Society. Serie B (Metodologisk), vol. 39, nr. 1, s. 1ñ 38.

Gupta ,M. & Chen, Y. (2010) Teori Og Bruk AV Em-Algoritmen. Fundamenter og Trender I Signalbehandling, Vol. 4, nr. 3 223-296.

Stephanie Glen. «Em Algoritme (Forventning-maksimering): Enkel Definisjon » Fra StatisticsHowTo.com Elementær Statistikk for resten av oss! https://www.statisticshowto.com/em-algorithm-expectation-maximization/

——————————————————————————

Trenger du hjelp med lekser eller testspørsmål? Med Chegg Study kan du få trinnvise løsninger på dine spørsmål fra en ekspert på feltet. Din første 30 minutter med En Chegg veileder er gratis!