Estimación de Máxima Verosimilitud > Algoritmo EM (Maximización de expectativas)

Es posible que desee leer este artículo primero: ¿Qué es la Estimación de Máxima Verosimilitud?

¿Qué es el algoritmo EM?

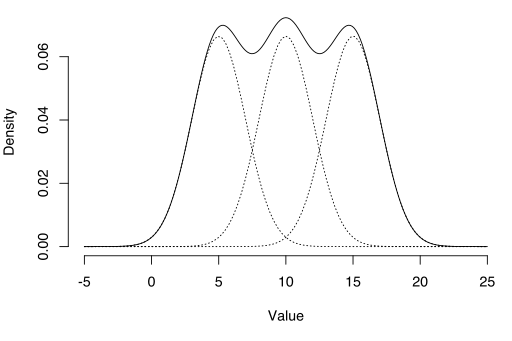

El algoritmo EM se puede usar para estimar variables latentes, como las que provienen de distribuciones de mezcla (sabes que provienen de una mezcla, pero no de qué distribución específica).

El algoritmo de maximización de expectativas (EM) es una forma de encontrar estimaciones de máxima verosimilitud para parámetros del modelo cuando los datos están incompletos, faltan puntos de datos o tienen variables latentes no observadas (ocultas). Es una forma iterativa de aproximar la función de máxima verosimilitud. Si bien la estimación de máxima verosimilitud puede encontrar el modelo «más adecuado» para un conjunto de datos, no funciona particularmente bien para conjuntos de datos incompletos. El algoritmo EM más complejo puede encontrar parámetros del modelo incluso si le faltan datos. Funciona eligiendo valores aleatorios para los puntos de datos faltantes y utilizando esas conjeturas para estimar un segundo conjunto de datos. Los nuevos valores se utilizan para crear una mejor estimación para el primer conjunto, y el proceso continúa hasta que el algoritmo converge en un punto fijo.

Véase también: Algoritmo EM explicado en una imagen.

MLE vs. EM

Aunque la Estimación de Máxima Verosimilitud (MLE) y EM pueden encontrar los parámetros «más adecuados», la forma en que encuentran los modelos es muy diferente. MLE acumula todos los datos primero y luego los usa para construir el modelo más probable. EM adivina primero los parámetros, teniendo en cuenta los datos faltantes, y luego ajusta el modelo para que se ajuste a las conjeturas y los datos observados. Los pasos básicos para el algoritmo son:

- Se realiza una estimación inicial de los parámetros del modelo y se crea una distribución de probabilidad. Esto a veces se llama el» E-Step «para la distribución» Esperada».

- Los nuevos datos observados se introducen en el modelo.

- La distribución de probabilidad del paso E se ajusta para incluir los nuevos datos. Esto a veces se llama el «paso M».»

- Los pasos del 2 al 4 se repiten hasta que se alcanza la estabilidad (es decir, una distribución que no cambia del paso E al paso M).

El algoritmo EM siempre mejora la estimación de un parámetro a través de este proceso de varios pasos. Sin embargo, a veces se necesitan algunos inicios aleatorios para encontrar el mejor modelo porque el algoritmo puede afinar en un máximo local que no está tan cerca del máximo global (óptimo). En otras palabras, puede funcionar mejor si lo fuerzas a reiniciar y tomas esa «conjetura inicial» del Paso 1 de nuevo. De todos los parámetros posibles, puede elegir el que tenga la mayor probabilidad máxima.

En realidad, los pasos implican un cálculo bastante pesado (integración) y probabilidades condicionales, lo que está más allá del alcance de este artículo. Si necesita un desglose más técnico (es decir, basado en cálculos) del proceso, le recomiendo encarecidamente que lea el documento de 2010 de Gupta y Chen.

Aplicaciones

El algoritmo EM tiene muchas aplicaciones, incluyendo:

- Desenredar señales superpuestas,

- Estimar modelos de mezcla gaussiana (GMM),

- Estimar modelos de Markov ocultos (HMM),

- Estimar parámetros para distribuciones de Dirichlet compuestas,

- Encontrar mezclas óptimas de modelos fijos.

Limitaciones

El algoritmo EM puede ser muy lento, incluso en el ordenador más rápido. Funciona mejor cuando solo tiene un pequeño porcentaje de datos faltantes y la dimensionalidad de los datos no es demasiado grande. Cuanto mayor sea la dimensionalidad, más lento será el paso en E; para datos con una dimensionalidad mayor, puede encontrar que el paso electrónico se ejecuta extremadamente lento a medida que el procedimiento se acerca a un máximo local.

Dempster, A., Laird, N., and Rubin, D. (1977) Maximum likelihood from incomplete data via the EM algorithm, Journal of the Royal Statistical Society. Series B (Methodological), vol. 39, no. 1, pp 1ñ38.

Gupta, M. & Chen, Y. (2010) Teoría y uso del algoritmo EM. Foundations and Trends in Signal Processing, Vol. 4, Nº 3 223-296.

Stephanie Glen. «Algoritmo EM (Expectativa-maximización): Definición Simple » De StatisticsHowTo.com: ¡Estadísticas elementales para el resto de nosotros! https://www.statisticshowto.com/em-algorithm-expectation-maximization/

——————————————————————————

Necesito ayuda con una tarea o cuestión de prueba? Con Chegg Study, puede obtener soluciones paso a paso a sus preguntas de un experto en el campo. ¡Tus primeros 30 minutos con un tutor de Chegg son gratis!